Your new post is loading...

Your new post is loading...

Passer d'un monde contrôlé par une trentaine d'algorithmes (10 + 10 + 10) à un monde sans algorithmes. Ou à tout le moins arriver à habiter le réel, dans la sphère intime, personnelle, dans notre travail, dans nos loisirs, en parvenant à s'extraire de toute forme de guidance et/ou de déterminisme algorithmique que nous n'aurions pas choisi, dont nous ne serions pas conscients et dont l'intentionnalité réelle nous demeurerait obscure.

Rebecca Porter and I were strangers, as far as I knew. Facebook, however, thought we might be connected. Her name popped up this summer on my list of “People You May Know,” the social network’s roster of potential new online friends for me.

The People You May Know feature is notorious for its uncanny ability to recognize who you associate with in real life. It has mystified and disconcerted Facebook users by showing them an old boss, a one-night-stand, or someone they just ran into on the street.

These friend suggestions go far beyond mundane linking of schoolmates or colleagues. Over the years, I’d been told many weird stories about them, such as when a psychiatrist told me that her patients were being recommended to one another, indirectly outing their medical issues.

Le premier est suédois, professeur de philosophie à Oxford et l’un des leaders du courant transhumaniste, depuis qu’il a fondé en 1998 la World Transhumanist Association (devenue depuis Humanity+). En 2014, il prédisait dans son livre Superintelligence : chemins, dangers, stratégies, recommandé par Elon Musk et Bill Gates, l’arrivée prochaine d’une superintelligence qui surpassera l’intelligence humaine. Le second, médecin, co-fondateur de Doctissimo et entrepreneur, est devenu le porte-parole français le plus virulent du débat sur l’avenir de l’intelligence artificielle, et se défend d'être transhumaniste. Nick Bostrom et Laurent Alexandre se sont succédés à Paris sur la scène de l’USI, conférence dédiée aux professionnels et à l'avenir du numérique et du monde. Usbek & Rica s'est glissé dans le public pour tenter de résoudre l'équation suivante : deux gourous + une IA = zéro chance de s'en sortir ?

La loi pour une République numérique du 7 octobre 2016 a confié à la CNIL la mission de conduire une réflexion sur les enjeux éthiques et les questions de société soulevés par l’évolution des technologies numériques. Elle a choisi de consacrer les premières réflexions au thème des algorithmes et de l’intelligence artificielle en initiant un cycle national de débats publics, ateliers ou rencontres, dans une démarche associant de très nombreux partenaires.

L'explication du vote Trump viendra en temps et en heure. En attendant, nous pouvons essayer de comprendre pourquoi personne ou presque ne semble avoir anticipé ce résultat.

Le nez collé au smartphone, happé par des contenus divertissants sans substance, le citoyen n'a pas vu la nouvelle règle du jeu arriver, selon laquelle l'algorithme décide au mépris des libertés.

Dans La nouvelle servitude volontaire (éditions FYP), Philippe Vion-Dury, journaliste et essayiste, s'attaque avec rigueur et lucidité à la mutation en cours de la société sous l'effet du numérique. Le « futur » tel qu'imaginé par la science-fiction est bien là, mais il n'est pas encore aussi spectaculaire. Et c'est bien pour cette raison, dit l'auteur, que cette révolution est dangereuse. Insidieuse, elle échappe au contrôle politique, n'est que peu remise en cause par les médias, et les algorithmes auto-apprenants deviennent si complexes, qu'ils ne seront bientôt plus compris par personne. À la source, le capitalisme libéral et son insatiable quête de profit pousse les entreprises à plus de rationalité et de rentabilité. Au grand dam de l'éthique et de la liberté, y compris dans les médias.

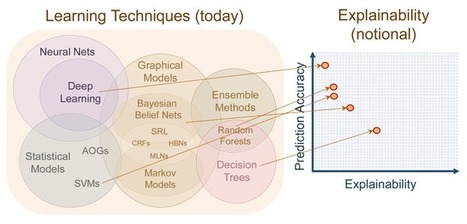

Via Bernard BRUNET

Le problème de l’apprentissage automatisé et des réseaux de neurones, principales techniques faisant tourner les programmes d’intelligence artificielle, repose sur le fait que même pour ceux qui les programment, leurs résultats sont souvent inexplicables. C’était le constat que dressait déjà Wired il y a quelques mois. C’est le même que dresse Nautilus. La difficulté demeure d’expliquer le modèle, estime le chercheur Dimitry Malioutov, spécialiste du sujet chez IBM. Ces programmes utilisent des données pour y trouver des schémas, mais même ceux qui les programment ont du mal à expliquer comment ils fonctionnent. Ce qui signifie à la fois qu’on a du mal à prédire leurs échecs et que leurs résultats sont difficilement interprétables… Alors que l’Union européenne vient de se prononcer pour un droit à l’explication des décisions automatisées, permettant aux citoyens de demander une forme de transparence des algorithmes, reste à savoir ce que signifie exactement cette transparence. Doit-elle être une explication ou une appréciation de sa complexité ?

Les données, nous répète-t-on à l'envi, sont le pétrole du XXIe siècle. Mais alors, à qui appartient le pétrole ? Au producteur, autrement dit à vous et moi qui tous les jours mettons nos données en circulation ? Ou aux Gafa et autres plates-formes qui les commercialisent ? A cette question centrale, la loi pour une République numérique, tout juste votée à l'Assemblée, ne répond pas. L'article 16 consacre certes la « libre disposition des données à caractère personnel ». Mais libre disposition n'est pas propriété. La logique de la loi, comme celle des textes européens dont elle s'inspire, est de conférer des droits à l'individu sur ses données (droit à l'oubli, droit testamentaire, droit à la portabilité…) et des obligations aux plates-formes qui les utilisent (neutralité vis-à-vis des contenus, lisibilité des conditions d'utilisation…). Cette approche strictement juridique donnera du travail aux avocats, sans traiter les racines du problème : aujourd'hui, nos informations les plus intimes sont éparpillées sur le Net, cédées en échange de services dont la gratuité repose sur le traitement de nos données, en particulier via le reciblage publicitaire. Nous sommes devenus de la chair à algorithmes, victimes de la plus formidable extorsion de valeur des temps modernes.

Via Bernard BRUNET

Bi Et si le big data venait enfin à bout du chômage en France ? Paul Duan, génie français de 23 ans en est en tout cas persuadé. Ce surdoué, expert en algorithmes, a ainsi réussi à convaincre Pôle Emploi de lui ouvrir sa base de données afin de personnaliser davantage les propositions d’emploi et réduire enfin ce fléau.

Via Loïc CARO, Aurélien BADET

Co-produisant une matière numérique nouvelle, humains et algorithmes collaborent d’une façon inédite dans l’histoire pour créer. Mais comment s’organise cette nouvelle culture algorithmique ? Nicolas Nova répond à nos questions.

Des glitchs à l’écran, des recommandations farfelues qui nous suivent sur Internet après une simple recherche, ou encore des bots Twitter qui likent toutes les occurrences du terme « jacuzzi » sur le réseau social… Les machines laissent de nombreuses traces étranges au sein d’un univers dans lequel nous faisons bien plus que coexister.

Sur Slate.com, la réalistrice et juriste, diplômée de l’école de droit de Yale, Rebecca Wexler nous rappelle que les programmes dont on ne peut accéder au code sont partout : dans les ascenseurs, dans les avions, dans les appareils médicaux, etc. L’impossibilité à y accéder à des conséquences directes sur la société et la politique… Ils peuvent menacer notre vie privée en recueillant des informations sur chacun d’entre nous sans notre consentement. Ils opacifient les critères pour déterminer votre admissibilité à des prestations sociales ou à des services, peuvent nous placer sur des listes noires… Pire encore, ils peuvent nous envoyer en prison.

Alors que les pays présentent les uns après les autres leur plan d’action climat en vue de la Conférence des Nations unies sur les changements climatiques (COP21) qui se tiendra à Paris en décembre 2015, un collectif international de chercheurs milite pour la création d’un « Code de la biosphère » à même de contrôler les algorithmes qui participent, selon eux, de la destruction de l’environnement. Retour sur cette initiative avec Motherboard.

Une nouvelle version des futurs programmes pour les classes allant du CP à la 3ème a été dévoilée. L'intégration de la "dimension numérique" est toujours d'actualité, dès le CP. Un enseignement de l'algorithmique et de la programmation est prévu à partir de la 5ème, avec un éveil avant.

|

Alors que le projet de loi adaptant le droit français au RGPD autorise les acteurs publics à prendre des décisions individuelles sur le seul fondement d’algorithmes, le Conseil constitutionnel a lancé un message clair aux administrations : faute de transparence, ces actes pourront être annulés.

À ce jour, aucune « décision produisant des effets juridiques à l'égard d'une personne » ne peut être prise sur le seul fondement d'un « traitement automatisé de données destiné à définir le profil de l'intéressé ou à évaluer certains aspects de sa personnalité ». Une protection posée par la loi « Informatique et Libertés » de 1978, notamment en vue d’éviter les profilages.

Last fall, University of Virginia computer science professor Vicente Ordóñez noticed a pattern in some of the guesses made by image-recognition software he was building. “It would see a picture of a kitchen and more often than not associate it with women, not men,” he says.

That got Ordóñez wondering whether he and other researchers were unconsciously injecting biases into their software. So he teamed up with colleagues to test two large collections of labeled photos used to “train” image-recognition software.

My family has grown very attached to our Amazon Echo, particularly for music. We can access Prime Music by asking Alexa for an artist, song, or station. Even my young kids can navigate the verbal interface to request “Can’t Fight the Feeling” from the movie Trolls or the soundtrack to the musical Hamilton.

As part of the smart speaker’s artificial intelligence, the program picks up on our tastes and preferences, so when we simply say “Alexa, play,” the device will queue up suggested tracks. In theory, what it picks should have some obvious relationship to music we chose ourselves. And songs it selects usually do. Usually.

But recently, Alexa considered our diet of kids’ music, show tunes, the Beatles, the Rat Pack, and Pink Martini, and decided to cue up … Sir Mix-a-Lot.

A l'heure de la multiplication des sources et des nouveaux moyens d'informations, les nouvelles générations composent avec une mappemonde informationnelle qui n'a plus grand rapport avec celle de leurs parents. Publié cette semaine, le rapport américain How youth navigate the News Landscape scrute les comportements des jeunes vis-à-vis de l’info, et s’intéresse à l’influence des smartphones, des réseaux sociaux, et des algorithmes sur les habitudes de lecture. Evidemment, ces observations donnent des indications plus générales sur le nouvel écosystème de l’info, bien au-delà des classes d’âge (nous sommes tous aujourd’hui plus ou moins soumis aux biais algorithmiques et à l’omnipotence de Facebook).

Comme toutes constructions humaines, codes et algorithmes comportent des biais, dont il est aujourd’hui complexe de cerner l’impact réel. Au point que certains chercheurs en font un terrain d’études à part entière.

Qu’il s’agisse d’une « peur des algorithmes » chez la sociologue Zeynep Tufekci, du principe de « bulles de filtres » développé par le militant Eli Pariser ou encore d’une démonstration factuelle des conséquences des algorithmes biaisées, cette science qui façonne le web tel que nous le connaissons, avec ses suggestions de plus en plus pointues et ses classements en termes de pertinence, ne fait plus qu’intriguer : elle peut aussi effrayer.

Il y a peu, la chercheuse danah boyd a réalisé une intervention remarquée lors du Personal Democracy Forum 2016 (PDF), intitulée Be Careful What You Code For (« Codeurs, faites attention à ce que vous faites »). « C’était une provocation », nous explique-t-elle. « Mais si vous ou vos lecteurs vous en emparez, tant mieux ! ».

Qu’y a-t-il sous le capot de la « machine » Admission post-bac (APB), qui permet d’effectuer ses vœux d’inscription dans l’enseignement supérieur ? Des irrégularités juridiques et une opacité de fonctionnement que le ministère va devoir lever rapidement au vu des décisions juridiques et administratives intervenues depuis le mois de juin.

La dernière en date provient de la Commission d’accès aux documents administratifs (CADA). Dans un avis communiqué vendredi 16 septembre que Le Monde a pu consulter, celle-ci informe l’association Droits des lycéens qu’elle est bien en droit d’obtenir du ministère de l’éducation nationale la communication du « code source » de l’algorithme APB. L’association réclame depuis de longs mois cet algorithme qui préside aux destinées de près de 800 000 élèves ou étudiants chaque année et dont le ministère s’était contenté de publier en juin les règles basiques de fonctionnement.

Please, please, Facebook, don’t kill clickbait headlines before I’ve had a chance to find out what she saw when she looked under the cushions and caused the headline writer to be SHOCKED!!!

Listen to reason, for mercy’s sake: I don’t even know what happened after he put garlic in his shoes before going to bed, but I’ve been told by another headline that it’s hard to believe.

Oh, excuse me, I meant It’s HARD to BELIEVE!!!!

Dans un texte publié dans Le Devoir du 12 janvier (« Uber et le nécessaire contrôle social des algorithmes »), le chercheur Yves Gingras soulevait la question fort pertinente de l’opacité des algorithmes utilisés par les services numériques auxquels nous sommes de plus en plus habitués dans notre société (par exemple Uber). Le sujet était à nouveau discuté à l’émission de radio Médium large le 14 janvier. Cet enjeu nous interpelle en tant que citoyens et militants de l’informatique libre.

La philosophie du logiciel libre, croyons-nous, jette une lumière essentielle sur les enjeux du numérique et, espérons-le, aidera le public québécois à s’y retrouver un peu mieux.

Aux Etats-Unis, plusieurs départements de police utilisent des algorithmes pour prévenir la criminalité. Le problème selon The Guardian ? Sont considérés comme suspects des gens qui n’ont… encore rien fait de répréhensible...

« Beware » : c’est le nom du logiciel utilisé par plusieurs départements de police aux Etats-Unis, dont celle de Fresno, en Californie, ou encore de Chicago, qui croise des milliards de données telles que des procès-verbaux, des registres de propriété, des recherches internet ou même des posts sur les réseaux sociaux.

Croisées, ces données permettent de déterminer un code couleur individuel de menace allant du vert au rouge en passant par le jaune.

Mais comment utiliser ces données lorsque les individus n’ont encore rien fait ? A cet égard, l’exemple du département de police de Chicago est particulièrement éclairant : en février 2014, plusieurs membres des forces de l’ordre se sont rendus au domicile de personnes présentées comme potentiellement suspectes, mais qui n’avaient réellement commis aucun acte répréhensible. Les officiers leur ont donc fait savoir qu’ils continueraient à les surveiller…

Une procédure qui, en enfermant le public dans une posture de suspect potentiel et en accroissant la défiance des populations à leur égard, peut s’avérer totalement contre-productive, conclut le Guardian.

Ils menacent nos emplois, quand ce n'est pas l'humanité tout entière : les robots sont-ils vraiment nos ennemis les plus redoutables ? Pour le New York Times, c'est plutôt des menaces pernicieuses des algorithmes dont il faudrait s'inquiéter...

Dans la quête vers des voitures autonomes, nous évoquions en juillet dernier le recrutement de plus en plus fréquent de philosophes par les constructeurs automobiles. La MIT Technology Review présente les résultats des premières recherches destinées à éclairer les dilemmes moraux et éthiques posés par ces véhicules.

Les algorithmes et les données assurant des décisions nous concernant sans transparence sont dénoncés dans « Black Box Society », de Franck Pasquale, aux Editions Fyp.

Professeur de droit américain, Franck Pasquale a écrit un ouvrage à charge sur la logique des boites noires. Cet ouvrage est aujourd'hui publié, traduit en Français, par Fyp Editions. Le principe de la boite noire est celui d'une décision algorithmique. Soient un ensemble de données et une question, un traitement va permettre de prendre une décision relative à cette question, sans intervention humaine et extrêmement rapidement. Cette décision peut être un simple score mais ce score peut avoir une grosse influence, par exemple un score de solvabilité va entraîner une acceptation ou un refus de prêt.

|

Your new post is loading...

Your new post is loading...

Your new post is loading...

Your new post is loading...